最新发布第2页

DeepSeek API 超详细使用指南 – 配套文档

本文档主要分为四部分,点击下方按钮可快速跳转AI 对话客户端DeepSeek API 合集主流大语言模型 API 合集推理模型合集AI 对话客户端 名称链接备注Cherry Studiohttps://cherry-ai.com/推荐使用,...

电脑录屏软件班迪录猎录屏屏幕录像录制声音高清4k无水印视频录制

超清画质,流畅录制支持4K/1080P高清录制,帧率自定义(最高60FPS),完美呈现游戏、视频、设计等细节。智能压缩技术,录制文件体积小,画质无损!灵活录制模式全屏/区域/窗口录制:自由选择任...

局域网内其他设备访问本地部署的deepseek,实现手机畅快问答

目的 使用ollama + pageassist + deepseek大模型,实现局域网内访问本地部署的大模型,手机也能畅快问答。 使用LmStudio + deepseek + vscode(continue) ,实现低配置电脑也可快速生成代码。 1....

ComfyUI和WebUI共用模型存放路径(节省空间)

减少模型的重复节省空间如何操作呢:2.58 复制打开抖音,看看【小雅 Aya的作品】【Comfyui系列教程】第二集:模型文件的管理和... https://v.douyin.com/4Jkj9HUC1Dc/ zGI:/ 01/25 M@j.Cu

ComfyUI AI系统课程新

🍭课程服务 ✅Comfyui助教服务1V1答疑 ▪️ ▪️学习过程中有任何问题,都可以直接问!!! ✅服务无期限 ▪️ ▪️服务没有期限!!! ✅课程一直更新 ▪️ ▪️因为目前AI处于一个高速发展的时期,...

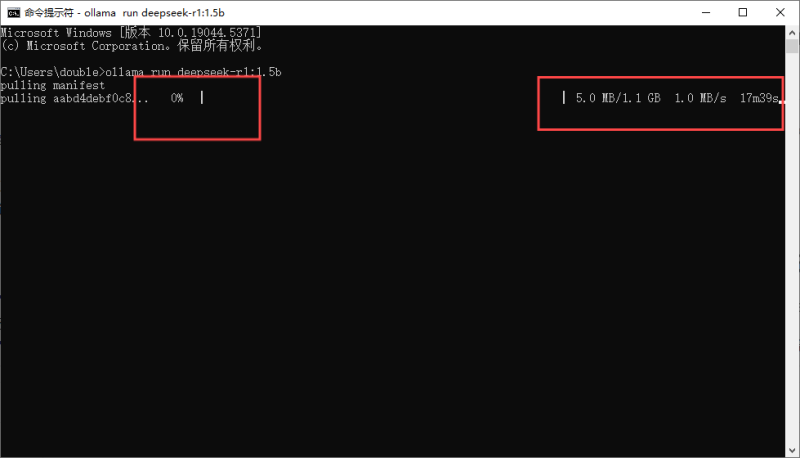

Ollama+DeepSeek本地部署教程及相关资料

环境准备 操作系统: 支持 macOS、Linux(推荐 Ubuntu/Debian)或 Windows(需 WSL2)。 确保系统已安装最新驱动和依赖库。 硬件要求: CPU:建议至少 4 核以上。 内存:16GB+(7B 模型需 8GB+...

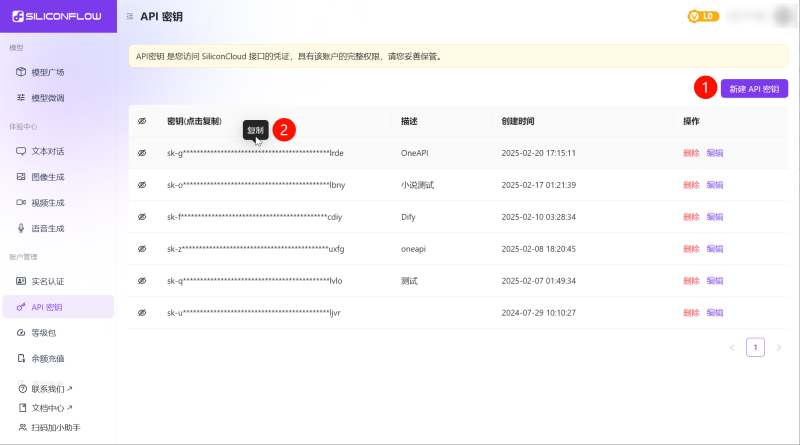

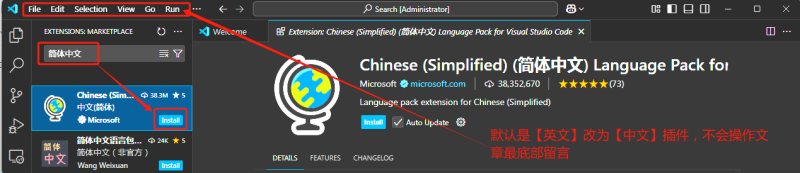

vscode接入deepseek

第一步下载vscode并安装简体中文-vscode安装包已上传网盘第二步安装Continue插件-插件已上传网盘第三步添加模型第四步申请Deepseek官方API-api快捷方式已上传网盘第六步把创建好的Deepseek的API...

comfyUI商业学习路径

AI资料库相关内容涵盖AI基础认知、在线应用工具、模型使用教程、电脑配置推荐、实战案例等,为学习者提供全面AI学习资源与指导。关键要点包括:AI基础认知:AI是模拟、延伸和扩展人类智能的技术...

AI软件Grok3苹果手机安装教学

Grok 3是什么 Grok AI是由埃隆·马斯克旗下的xAI公司开发的一系列人工智能模型,旨在通过强大的自然语言处理和推理能力,为用户提供更加智能、高效的交互体验。Grok 3作为该系列的最新版本...