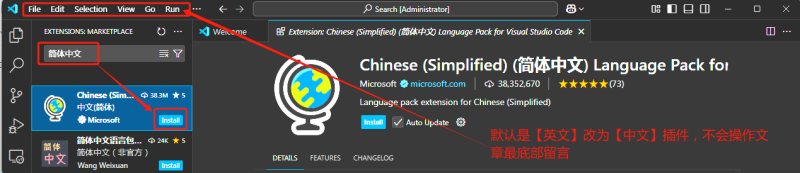

vscode接入deepseek

第一步下载vscode并安装简体中文-vscode安装包已上传网盘第二步安装Continue插件-插件已上传网盘第三步添加模型第四步申请Deepseek官方API-api快捷方式已上传网盘第六步把创建好的Deepseek的API...

使用腾讯云HAI+ChatBox部署个人DeepSeek应用

前言 你好,我是喵喵侠。之前我在文章中介绍过,如何借助腾讯云HAI部署DeepSeek。在这个基础上,你可以借助ChatBox AI,来实现在电脑、手机、平板上,使用DeepSeek进行对话。 ChatBox AI下载 首...

将 DeepSeek 接入 WPS,办公效率飞起

一、效果预览 接入 DeepSeek 后,WPS 将新增一个“DeepSeek”选项卡。选中文本后,点击“调用 DeepSeek”按钮,即可实现 AI 对话、写作、排版、绘画、校对、翻译、数据分析、公式执行等多种功能...

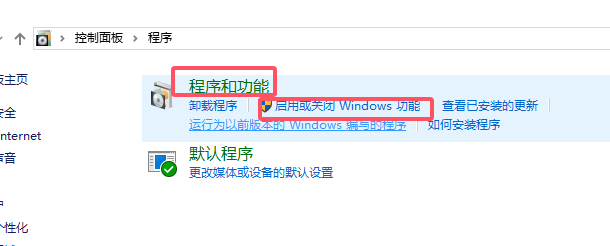

Dify在windows系统的docker中向本地部署的deepseek嵌入知识库提问

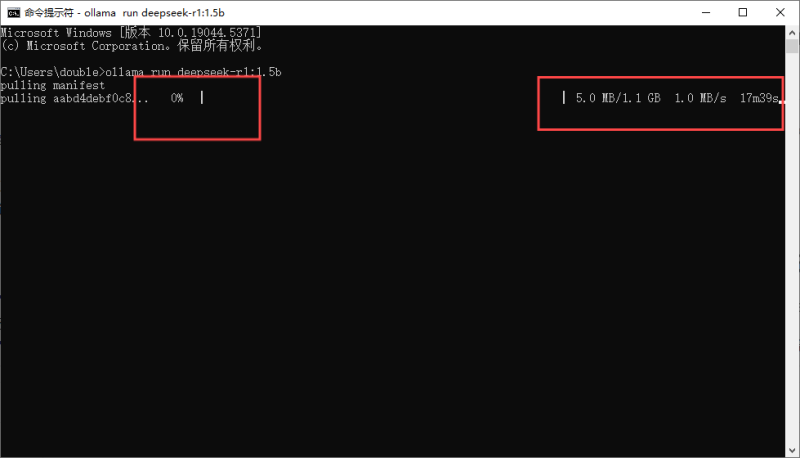

目的windows 安装docker本地部署 deepseek(ollama)本地部署 dify 并嵌入 知识库说明:本文档中的所有下载的相关资源都可以在右上角的群内容获取。1.设置windows环境开启Hyper-V打开 控制面板 ...

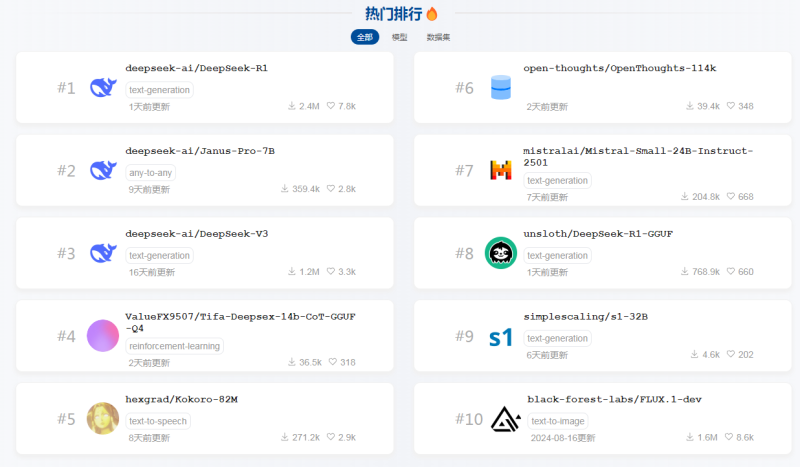

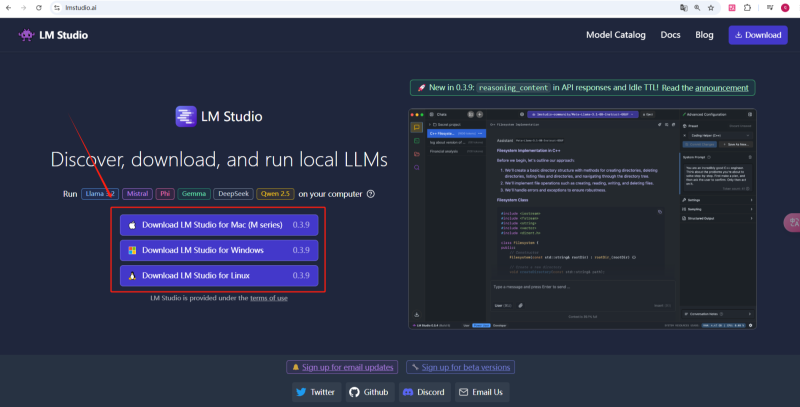

LM studio部署本地Deepseek精度模型包

DeepSeek模型选择和下载根据博主的提供的参数,先清楚自己能够使用多大的模型,再进行下载。根据自己电脑的显卡配置和需求选择合适的模型下载,可以先下载1个尝试,模型是可以下载多个并灵活切...

DeepSeek本地部署教程+可视化界面+入门操作指南

教程说明1、大家可以根据本文档步骤安装使用。2、看不懂文档的,可以看安装教程视频,跟着视频里一步一步操作。deepseek本地部署视频教程:https://26794125.s21v.faiusr.com/58/ABUIABA6GAAg5L...

LM Studioh和ollama在本地部署deepseek上有哪些技术优势

LM Studio 和 Ollama 都是用于本地运行大型语言模型(LLM)的工具,但它们在设计目标、使用方式和适用场景上有显著区别。以下是两者的详细对比: 1. 核心定位 特性 LM Studio Ollama 目标用户 ...

局域网内其他设备访问本地部署的deepseek,实现手机畅快问答

目的 使用ollama + pageassist + deepseek大模型,实现局域网内访问本地部署的大模型,手机也能畅快问答。 使用LmStudio + deepseek + vscode(continue) ,实现低配置电脑也可快速生成代码。 1....